- acasă

- >

- Nor

- >

- TDMQ pentru CKafka

- >

TDMQ pentru CKafka

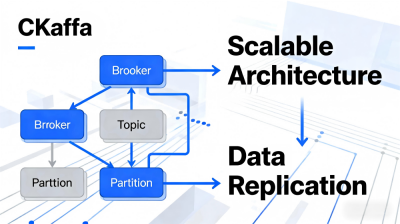

2025-12-12 16:24TDMQ pentru CKafka este un sistem de mesagerie distribuit, cu randament ridicat și scalabil, 100% compatibil cu Apache Kafka, suportând versiunile 0.9 până la 2.8. Bazat pe modelul de publicare/abonare, CKafka decuplează mesajele, permițând interacțiunea asincronă între producători și consumatori, fără a necesita așteptare reciprocă. CKafka oferă avantaje precum disponibilitate ridicată, compresie a datelor și suport pentru procesarea datelor offline și în timp real, ceea ce îl face potrivit pentru scenarii precum compactarea și colectarea jurnalelor, monitorizarea agregării datelor și integrarea fluxului de date. În ceea ce privește capacitățile de bază, CKafka acceptă integrarea profundă cu Big Data Suite (de exemplu, EMR, Spark) pentru a construi conducte complete de procesare a datelor. Valorificând implementarea distribuită extrem de fiabilă și scalabilitatea, CKafka permite extinderea orizontală a clusterelor și actualizări fără probleme ale instanțelor, sistemul subiacent scalându-se automat elastic pentru a se potrivi nevoilor afacerii. În scenarii cheie, ca o componentă critică a fluxului de date, Log Collection agregă eficient datele jurnalelor prin intermediul agenților client, oferind o sursă de date stabilă pentru procesarea fluxului de date. În scenariile de procesare a datelor în flux, combinat cu servicii precum Stream Compute SCS, permite analiza datelor în timp real, detectarea anomaliilor și reprocesarea datelor offline, deblocând complet valoarea datelor. Compatibilitatea cu Apache Kafka reduce bariera de acces pentru utilizatori, în timp ce adaptarea profundă la procesarea datelor în timp real și în flux, responsabilizarea colaborativă cu Big Data Suite și suportul eficient pentru Log Collection fac din CKafka o platformă centrală pentru fluxul de date la nivel de întreprindere și extragerea valorii.

Întrebări frecvente

Î: Tencent Cloud CKafka este 100% compatibil cu Apache Kafka. Ce valoare practică aduce această caracteristică scenariilor de procesare a datelor în flux și de date în timp real?

R: Tencent Cloud CKafka este complet compatibil cu versiunile 0.9 până la 2.8 de Apache Kafka, oferind suport esențial pentru scenariile de procesare a datelor în flux și date în timp real. În scenariile de procesare a datelor în flux, compatibilitatea cu Apache Kafka înseamnă că utilizatorii pot migra fără probleme logica de procesare a fluxurilor existentă bazată pe Kafka către platforma CKafka, fără modificări. De asemenea, pot reutiliza direct componente mature, cum ar fi Kafka Streams și Kafka Connect. Combinată cu integrarea dintre CKafka și Stream Compute SCS, aceasta permite o colaborare eficientă pentru analiza datelor în timp real, detectarea anomaliilor și procesarea datelor offline, reducând costurile de migrare și transformare a afacerii. În scenariile de date în timp real, compatibilitatea cu Apache Kafka permite utilizatorilor să continue să utilizeze modele de dezvoltare și lanțuri de instrumente familiare, integrând rapid datele de monitorizare în timp real și datele de afaceri. Natura distribuită și de mare randament a CKafka asigură recepția și transmiterea eficientă a datelor în timp real, prevenind întârzierile de date. În plus, valorificând avantajele ecosistemului aduse de compatibilitate, CKafka poate fi integrat rapid cu Big Data Suite pentru analiză imediată și extragerea valorii datelor în timp real. Funcția de compatibilitate cu Apache Kafka face ca implementarea scenariilor de procesare a datelor în flux și de date în timp real să fie mai lină și mai eficientă, protejând complet investițiile tehnice existente ale utilizatorilor.

Î: Cum oferă Tencent Cloud CKafka suport pentru date pentru Big Data Suite prin intermediul colectării de jurnal și cum funcționează cele două împreună în cadrul procesării datelor în flux?

R: Tencent Cloud CKafka oferă o sursă de date stabilă pentru Big Data Suite prin capacitatea sa eficientă de colectare a jurnalelor: Prin implementarea componentelor agentului client, CKafka poate colecta în mod cuprinzător diverse tipuri de date de jurnal, inclusiv jurnalele de execuție a aplicațiilor și jurnalele de comportament operațional. După agregare, datele sunt trimise uniform către clusterul CKafka, asigurând caracterul complet și natura în timp real a datelor de jurnal și oferind date de intrare de înaltă calitate pentru analiza și procesarea Big Data Suite. În cadrul procesării datelor în flux, CKafka și Big Data Suite lucrează împreună îndeaproape și eficient: În primul rând, datele masive colectate prin colectarea jurnalelor sunt stocate în CKafka. Big Data Suite (de exemplu, Spark în EMR) poate consuma date din CKafka în loturi pentru analiză și reprocesare offline, generând rapoarte de tendințe. În același timp, CKafka acceptă transmiterea de date în timp real, permițând Big Data Suite să citească datele în flux în timp real și să lucreze cu serviciile de calcul în flux pentru a efectua analize de date în timp real și detectarea anomaliilor, identificând rapid problemele sistemului. Colectarea de jurnal (Log Collection) servește drept punct de plecare pentru fluxul de date, iar eficiența sa asigură furnizarea surselor de date pentru suita Big Data. Colaborarea dintre cele două în cadrul Stream Data Processing realizează o acoperire completă a scenariilor, atât pentru datele în timp real, cât și offline, permițând extragerea completă a valorii datelor.

Î: În scenariile de procesare a datelor în timp real, care sunt avantajele combinării Tencent Cloud CKafka cu Big Data Suite și cum facilitează funcția de compatibilitate Apache Kafka conexiunea dintre colectarea jurnalelor și procesarea datelor în flux?

R: În scenariile de procesare a datelor în timp real, combinarea dintre Tencent Cloud CKafka și Big Data Suite oferă avantaje semnificative: CKafka dispune de un randament ridicat și o latență redusă, permițând recepționarea rapidă a unor volume masive de date în timp real, în timp ce Big Data Suite (de exemplu, Spark, EMR) oferă capacități puternice de calcul pentru analiza imediată, curățarea și extragerea valorii datelor în timp real. De asemenea, acceptă stocarea și reprocesarea datelor offline, satisfăcând diverse nevoi, cum ar fi monitorizarea în timp real și analiza tendințelor. În plus, implementarea cu un singur clic a conductelor de flux de date între CKafka și Big Data Suite reduce semnificativ costurile de configurare și întreținere a sistemului. Funcția de compatibilitate Apache Kafka facilitează o conexiune mai lină între colectarea jurnalelor și procesarea fluxului de date: În timpul fazei de colectare a jurnalelor, valorificând ecosistemul client compatibil cu Apache Kafka, utilizatorii pot utiliza direct instrumente mature de colectare a jurnalelor (de exemplu, Fluentd) pentru a se integra cu CKafka fără a dezvolta pluginuri de adaptare suplimentare, asigurând o colectare a jurnalelor eficientă și stabilă. În timpul fazei de procesare a datelor în flux, funcția de compatibilitate permite CKafka să se integreze perfect cu componentele de procesare a datelor în flux bazate pe protocolul Kafka, permițând un flux de date end-to-end fluent, de la colectarea jurnalelor, transmitere și procesare. Acest lucru evită problemele de compatibilitate în timpul transmiterii datelor și asigură continuitatea și eficiența procesării datelor în flux.